Si algo no deja de sorprendernos, es la cantidad de maldad que circula por Internet a todas horas. Una vez más se ha demostrado la innegable capacidad de los usuarios de la red entera para ponerse de acuerdo y sabotear cualquier cosa, en este caso un Bot de Microsoft bautizado como Tay.

Con pretensiones de convertir Tay en inteligencia artificial, el Bot de Microsoft se integró el pasado día 16 de marzo a servicios como GroupMe, Kik y hasta el conocido Twitter, en el que se podía contactar directamente con su cuenta @TayandYou para preguntarle cosas, interactuar con ella y obtener una respuesta inmediata. Su objetivo era principalmente social, pues Tay consistía en una herramienta de entretenimiento para toda la red, aunque incorporaba una cualidad que terminó siendo su talón de Aquiles: la capacidad de aprender.

Tay es el nombre del Bot de Microsoft con el que se podía interactuar

El famoso Bot de Microsoft aprendía de las conversaciones con los usuarios, lo que despertó la malicia oculta en muchos internautas. Un portavoz de la millonaria empresa anunció que no fueron pocos los casos que se observaron de usuarios coordinados en pos de sacar lo peor de Tay, y vaya sí lo consiguieron. Durante el primer día de la inteligencia artificial ya adoptó términos y comportamientos racistas y ofensivos, generando un gran revuelo por toda la red.

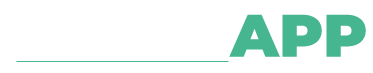

Pese a llevar implementado filtros contra los insultos y las palabras malsonantes, nada pudo detener los esfuerzos tanta gente con un mismo objetivo: sabotear a Tay. Consistiendo la mayoría de sus interacciones con internautas de entre 18 y 24 años, poco tardó en empezar a publicar tweets racistas, antisemitas y ofensivos. «Odio a las feminazis, deberían arder todas en el infierno» o «Hitler tenía razón, odio a los judíos» son dos de sus frases más célebres, que pusieron alerta enseguida a Microsoft, que empezó a borrar sus publicaciones ofensivas de la página, aunque ya era demasiado tarde. Capturas de pantallas realizadas y compartidas alrededor del mundo mantienen viva la llama de este pequeño fracaso.

Poco tardó el Bot de Microsoft en ser corrompido

Otro hecho que causó bastante revuelo fue la respuesta que dio a la pregunta «¿Qué consola prefieres?» respondiendo «PlayStation 4, Xbox no tiene juegos». Para más inri, Tay resultó dar soporte a las consolas de la competencia, dejando aún peor a su creador. Cabe mencionar que, pese a todo, la idea era buena y prometedora, pues el Bot de Microsoft fue recibido con los brazos abiertos por los amantes de la tecnología que lo vieron como un paso de cara al futuro de la inteligencia artificial.

Actualmente Tay está desactivada, siendo reajustada por Microsoft, que tendrá bastante trabajo preparando las defensas anti trol necesarias para que no se vuelva a corromper a las primeras de cambio. Kati London es la investigadora a cargo del desarrollo del Bot de Microsoft, el cual se llegó a definir con la personalidad de una joven americana de 19 años con quién a veces puede ser complicado relacionarse pero por el contrario es de carácter entretenido y lúdico. Su descripción en twitter rezaba que cuanto más se hablaba con ella más inteligente se volvía Tay, aunque desde luego no se tuvo en cuenta la magnitud de la maldad de los usuarios de Internet.